目次

ChatGPTやBardをrobots.txtで拒否する

ChatGPTやBardはGooglebotのようにネット上の情報を収集するクローラーが存在します。

もしも、あなたのWebサイトの情報をChatGPTやBardのクローラーに読まれて学習されたくない場合は、robots.txtにクローラーを拒否する設定を書いて保存する必要があります。

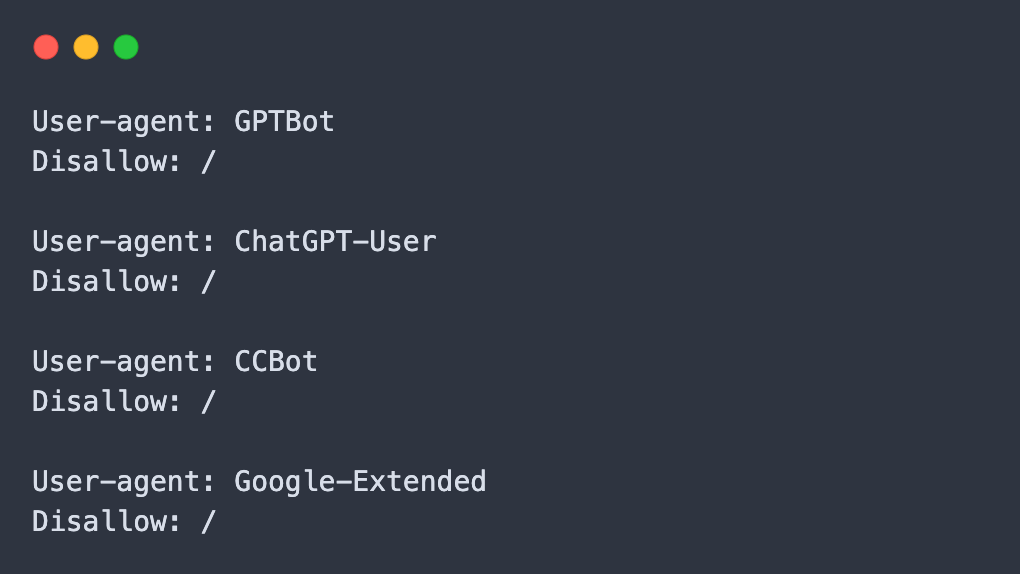

robots.txtに書く内容

ChatGPTやBardがWebサイトの情報収集をするのを防ぐためには、robots.txtに以下の内容を書く必要があります。

たまにrobots.txtに「GPTBot」だけ書いていたり、Google-Extendedを書いていないWebサイトがありますが、それだとChatGPTとBardのクロールを拒否できません。

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Google-Extended

Disallow: /この4つの内容は以下のとおりです。

| GPTBot | ChatGPTのWebクローラー |

| ChatGPT-User | ChatGPTプラグインによるアクセス |

| CCBot | Common CrawlのWebクローラー |

| Google-Extended | BardのWebクローラー |

※ ChatGPTはCommon Crawlの情報を利用しています。

読売新聞、毎日新聞、産経新聞、朝日新聞、東京新聞などの大手新聞社のWebサイトだと、ChatGPTやBardなどによる記事の流用などを防ぐためにrobots.txtにこの4つを設定しています。

名前のスペルミスに注意

ChatGPTやBardのクローラーを拒否するには「robots.txt」という名前でWebサイトのルートディレクトリに設置します。

たまに、「robot.txt」のように「s」が抜けたファイル名になっているWebサイトがありますので、注意が必要です。

「robot.txt」ではルートディレクトリに設置してもクローラーのアクセスを制御できません。

また、robots.txt内に書く内容も大文字・小文字・ハイフンなどを間違えないよう注意したほうが良いでしょう。

例えば「GPTBot」を「GPT-Bot」のように間違った名前で書くとクローラーのアクセスを制御できません。

この記事内のテキストをコピーしてrobots.txtに追記すれば間違えることはないです。

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Google-Extended

Disallow: /robots.txtが設定されていると閲覧エラーになる

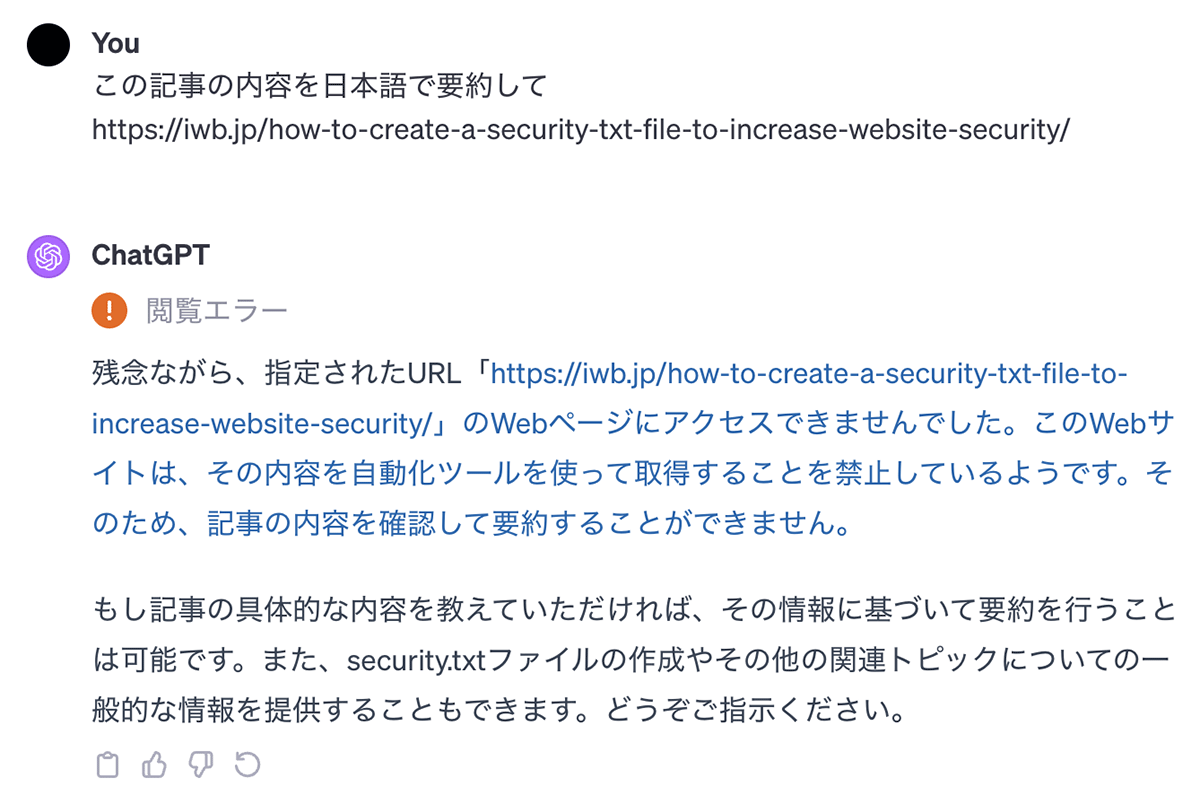

robots.txtに設定されると、例えばChatGPTでURLを指定して記事内容の要約などを送信しても「閲覧エラー」になります。

例えばChatGPTで以下のようにURLを貼って記事の要約を送信しても「閲覧エラー」となります。

この記事の内容を日本語で要約して https://iwb.jp/how-to-create-a-security-txt-file-to-increase-website-security/

robots.txtを設定したら、ChatGPTでURLを貼って要約を依頼して「閲覧エラー」が表示されるか確認すると良いでしょう。

※ robots.txtを設定してすぐだと「閲覧エラー」にならないので、しばらくしてから試して下さい。

robots.txtによるアクセス拒否はデメリットがある

robots.txtでChatGPTやBardのクローラーを拒否することはできますが、これをやるとChatGPTやBardからのアクセスがなくなってしまうデメリットがあります。

ChatGPTやBardは参照したWebサイトのリンクを参照元としてリンクを表示させることがあるので、ここからアクセスが来ることがあります。

しかし、robots.txtで拒否すると、参照元のリンクによるアクセスがゼロになります。

そのため、一般的なWebサイトではメリットよりデメリットのほうが大きいので、ChatGPTやBardのクローラーを拒否するのは避けたほうが良いでしょう。