robots.txtで一部の生成AIを拒否するとアクセス数が減る

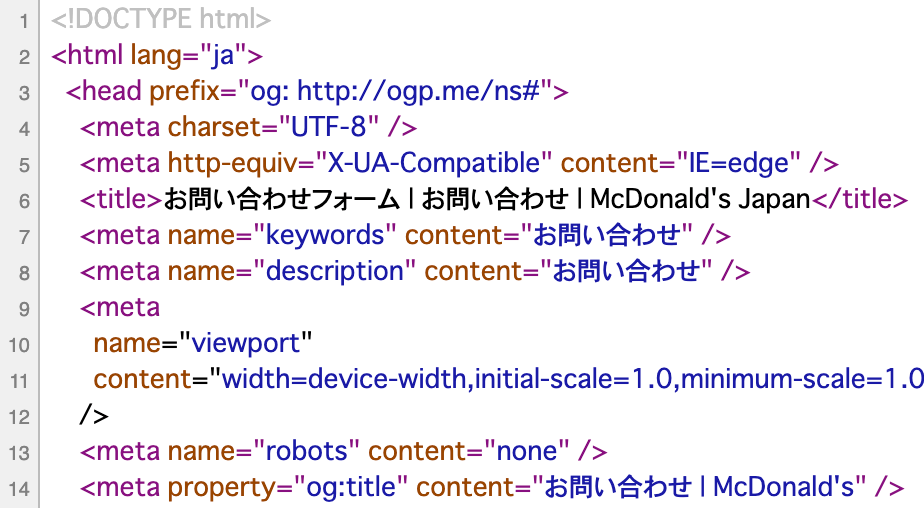

iwb.jpでは生成AIに記事内容を学習されて流用されないように、robots.txtのUser-agentに生成AIのクローラーの名前を指定して「Disallow: /」で拒否していました。

しかし、拒否する生成AIによっては記事のアクセス数が減ってしまうことがGoogleアナリティクスの結果などから判明しました。

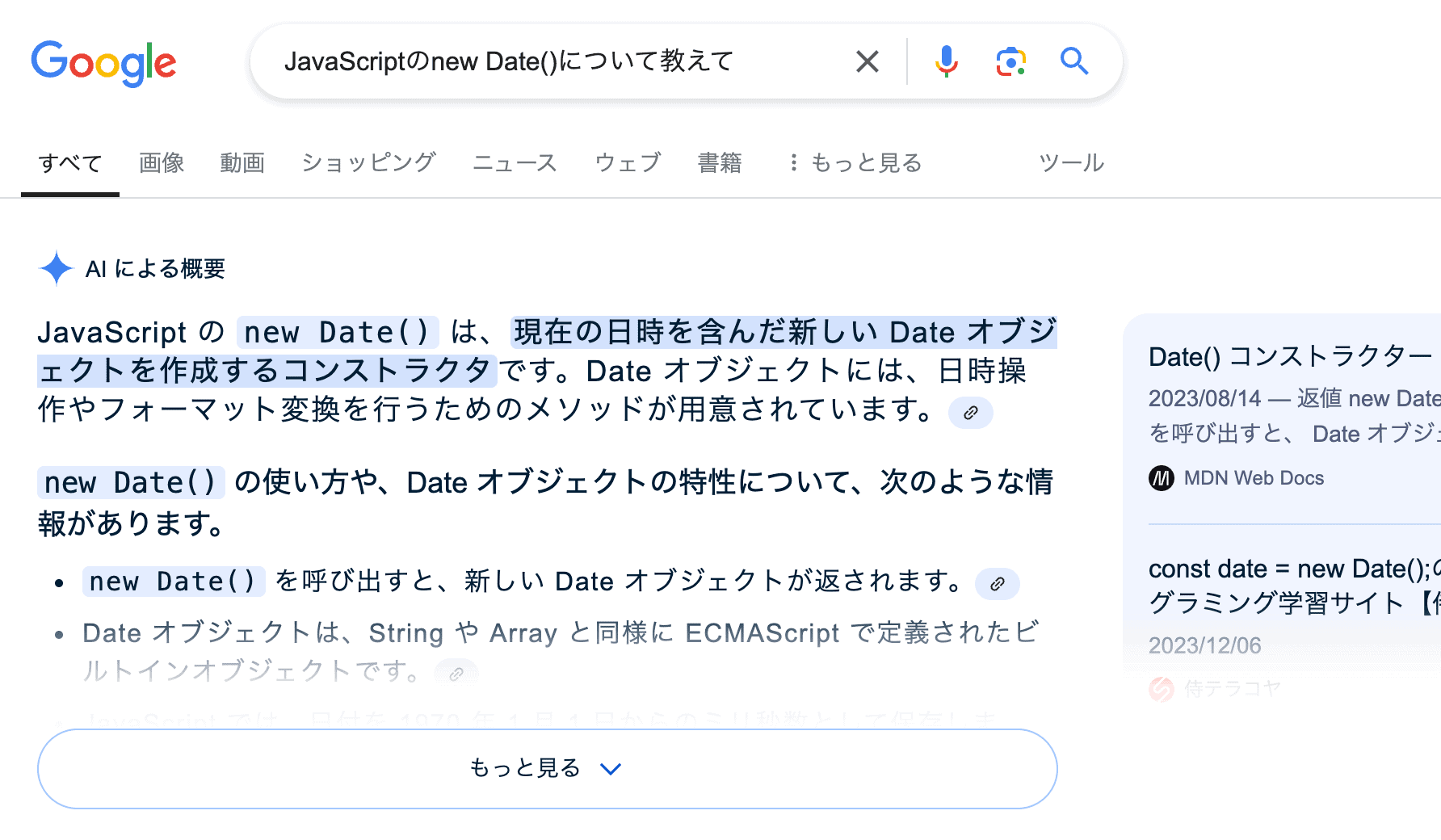

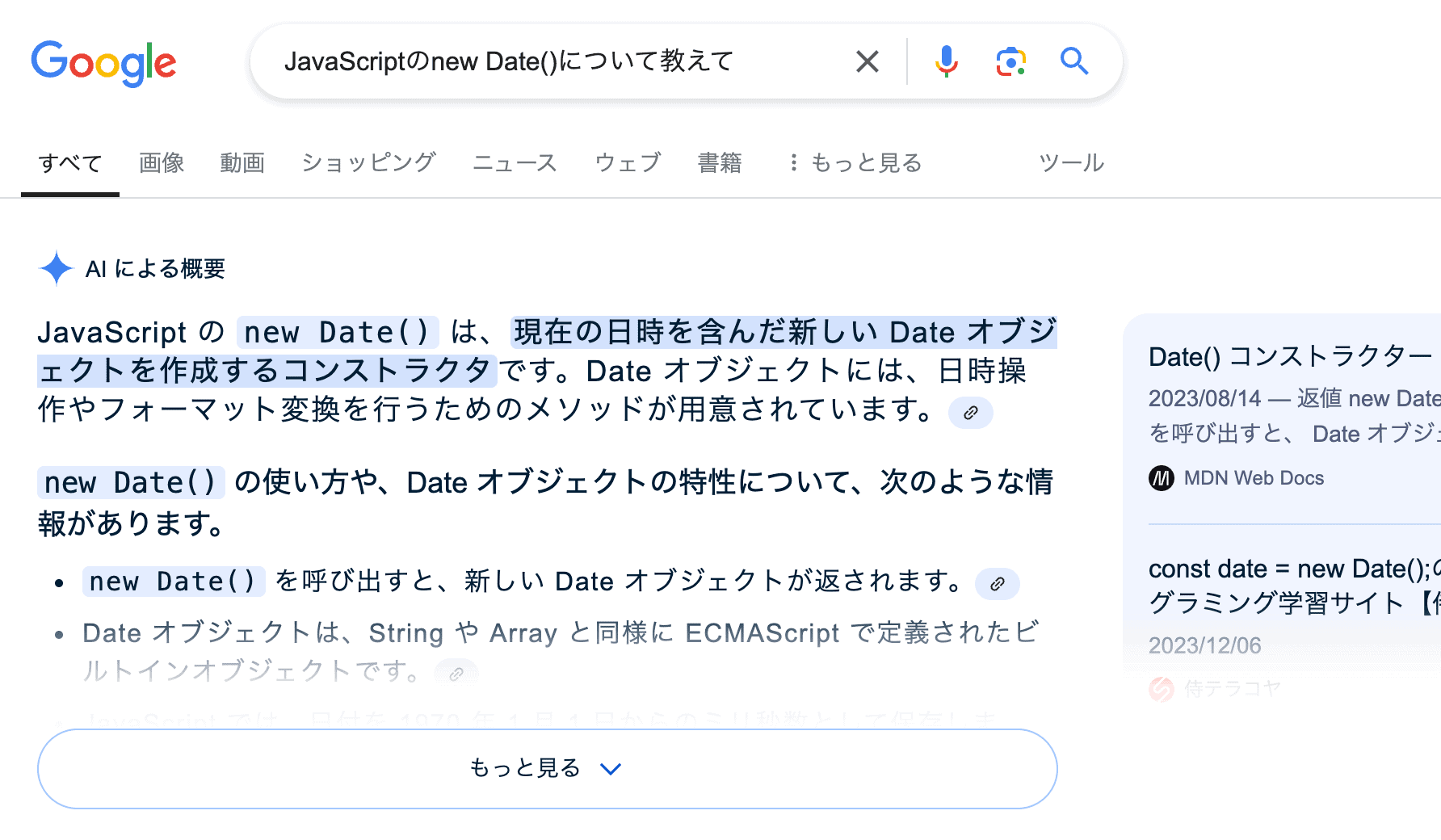

GoogleやPerplexityのように利用率が高く、情報を引用元のリンクを表示する生成AIの影響が大きいので、これらの生成AIはrobots.txtで拒否しないほうが良いです。

特に最近のGoogleは検索結果に「AIによる概要」と「引用元のリンク」を検索結果の最初に表示する仕様になったので影響は絶大です。

robots.txtで拒否しないほうが良いクローラー

robots.txtで拒否しないほうが良いクローラーは以下の2つです。

robots.txtに記載されている場合はWebサイトのアクセス数が減る可能性が高いので注意が必要です。

Google-Extended

Googleの生成AIのトレーニング用データ収集クローラー。

Google検索結果に引用元のリンクが貼られるので、Webサイトのアクセス数を減らしたくなければ拒否しないほうが良いです。

PerplexityBot

Perplexity AI(生成型AIを活用した検索サービス)のデータ収集クローラー。

日本国内での利用者が多く、関連性の高い引用元のリンクを表示する特徴があるため、Webサイトのアクセス数を減らしたくなければ拒否しないほうが良いです。

まとめ

robots.txtに以下の記述があって、データ収集クローラーを拒否するとWebサイトのアクセス数が減るため、アクセス数を減らしたくなければ削除することをオススメします。

User-agent: Google-Extended

Disallow: /

User-agent: PerplexityBot

Disallow: /